私たちは、ことを知っています Apple エコシステム内のデバイスを通過するデータの機密性にとって、データが覗き見から十分に保護されていることは非常に重要です。 ただし、ユーザーが倫理、道徳、さらには人間性に関する規則に従う必要がないという意味ではありません。

Apple は、ユーザーが保存したすべての画像をスキャンできるテクノロジーを間もなく開始すると発表しました。 iCloud 子供に対する性的虐待を含む写真を特定する。 児童性的虐待資料(CSAM)。

この技術はによって発売されます Apple 今年の終わりに向けて、おそらくパイロットバージョンで、少数のユーザー向けに。

「データの機密性はどこにあるのか」と疑問に思っている場合は、私たちが受け取るすべてのコンテンツを確認してください ビデオ/写真 それは暗号化されたプロトコルを介して行われます。 にデータを保存するだけでなく iCloud 暗号化されていますが、そのようなサービスのプロバイダーはデータを暗号化するための鍵を持っています。 ここでは、 Apple. Microsoft、Google、およびその他のデータ ストレージ サービス cloud 私も同じことをします。

保存されたデータは、法的措置で要求された場合、または法律に著しく違反している場合は、復号化して検証できます。 子供や女性に対する暴力行為に関するものなど。

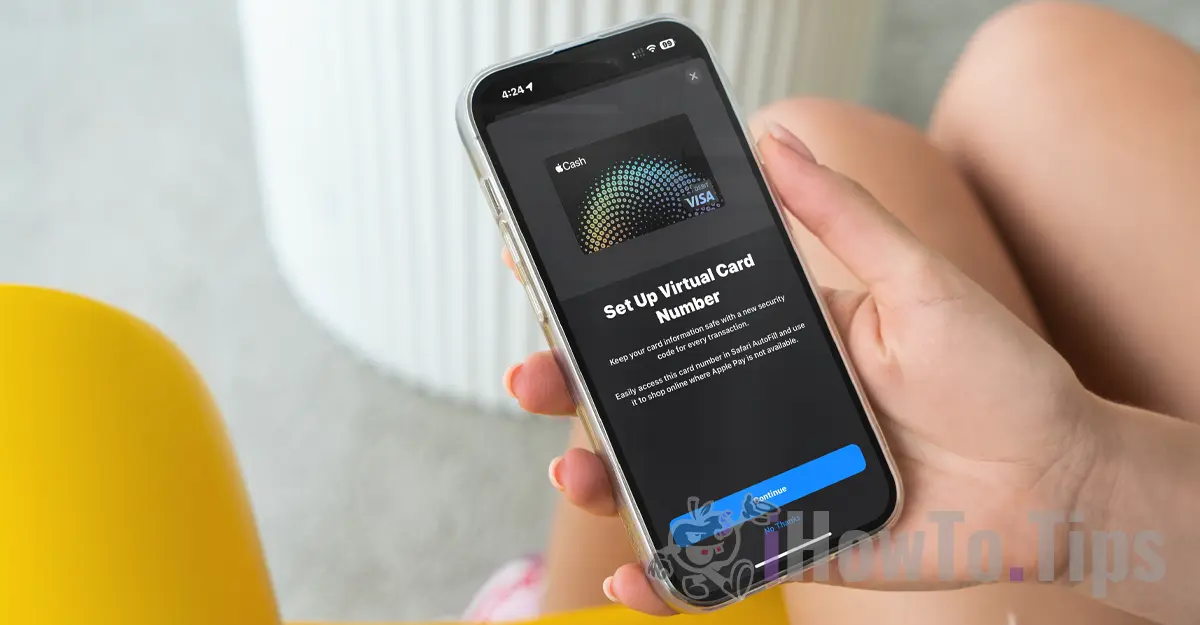

ユーザーの機密を保持するために、同社はNeuralHashと呼ばれる新しいテクノロジーに依存しています。 iCloud そして、データベース内の他の画像と比較することにより、子供に対する暴力を含むものを特定します。

これは、オブジェクト、動物、その他の要素の顔認識またはインテリジェント認識にいくぶん似ています。

この技術により、iPhone、iPad、または Mac デバイスを介して撮影または転送された写真が変更されている場合でも、スキャンして検証できるようになります。